宇树CEO 对“具身智能”和“人形机器人”未来的设想

- 体育赛事

- 2024-12-23 09:30:23

- 4

2024 年8 月,“2024 世界机器人大会”在京举行,期间举办了系列论坛,在8 月24 日下午的技术论坛上,主要话题是“人形机器人”,宇树科技CEO 兼CTO 王兴兴做了报告,题目是:“具身智能”指明了实现AGI的方向。

本文引用地址:

王兴兴首先向来参会的美国AI 研究所执行主任、波士顿动力公司创始人Marc Raibert(马克·雷伯特)致敬,说在他10 岁读小学时,看到了Marc 在MIT 实验室做的双足机器人和后空翻机器人,是从在中国引进的科技纪录片里,至今已二十几年。宇树公司2016年成立,至今也有8 年时间了。

王兴兴这次的报告是探讨具身智能和AGI 的方向。

1 OpenAI的早期研发也是机器人

OpenAI 早期的目标是实现AGI(通用人工智能)。实际上,该公司早年在机器人方面投入很大,但是由于GPT 发展很快,因此该公司后来在机器人的发展方向上投入资源较少。但是王兴兴坚信“具身智能”是更好实现AGI 的方向。

为什么这么说?王兴兴没有直接回答,而是先介绍了宇树机器人的发展历程。

2 宇树机器人的进展

● Xdog —— 公司成立前的机器狗原型

早在2013—2015/2016 年,王兴兴在读硕士期间做了XDog 机器人。当时初衷很简单,因为他一名学生没有那么多的资源去做一个很大的液压机器人,所以当时希望用一种简单的方法实现一个低成本、运动性能很好的方案,所以他当时就用盘式无刷电机,再加上自己开发的电机驱动板,实现了XDog 方案。该方案的研发投入只有一两万元。王兴兴在2015 年用这个机器人参加了上海的一个比赛,获得了二等奖,赢得了8 万元奖金。这笔奖金后来成为2016 年宇树公司注册时的启动资金。

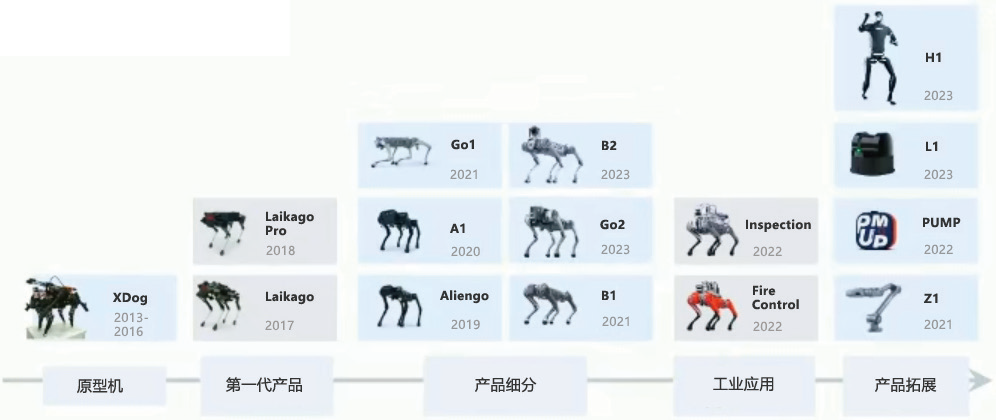

宇树后续的产品主要是做高性能四足机器人,2023年年初又开始做高性能人形机器人等技术产品(如图1)。代表性的产品如下。

● 四足机器人Go1

宇树目前的四足主机器人主要是两款。第一款是小一点的Go1,最大特点是搭载了自研的3D激光雷达,并且在2023 年就搭载了OpenAI 的ChatGPT 接口,用户可以直接用语音跟它对话,让它执行一些底层的动作,并且也试着集成了OpenAI 的多模态接口,用户可以问它前面有什么东西,它可以回答。

但是在开发过程中,发现目前的大语言模型和多模态模型对满足机器人的应用是非常不足的——它们对空间/ 整个物理世界的理解,包括对机器人本体的理解是远远不够的。所以希望未来有更好的机器人模型诞生。

当然这不可能仅指望一家公司,需要全球所有的实验室和科技公司一起推动。

● 工业级四足机器人B2

B2 也是2023 年发布的,是大一点的工业级四足机器人,最大的特点是负载和续航能力很强。对于大部分的工业场景,包括室内外、地下管廊或其他环境都是足够适用的,这也是宇树目前的一个主力型号。

● 人形机器人H1 和G1

在人形机器人方面,宇树目前发展也非常快。其实早在2009 年王兴兴读大一的时候,寒假就做过一个小的人形机器人,当时非常便宜,只用了200 元。但是做好以后他非常失望——不仅对自己感到失望,也对当时全球范围内人形机器人的科技发展速度感到有些失望。所以之后很多年,很多人问宇树做不做人形机器人?王兴兴非常坚决地回答“不做”。因为当时全球的技术及商业化程度,没有办法很好地推动人形机器人发展。但是在过去的几年,很多实验室用宇树的机器狗做AI开发,宇树也肉眼可见了强化学习在四足机器人里的飞速进展。并且在2022 年底时ChatGPT 横空出世,点燃了人们对生成式AI 影响机器人发展的信心。所以宇树在2023 年初开始做高性能人形机器。H1 人形机器是2023 年第一款人形机器人,最大特点是动力性能强大,可谓当时全球同类型电驱人形机器人中动力性最强的之一。

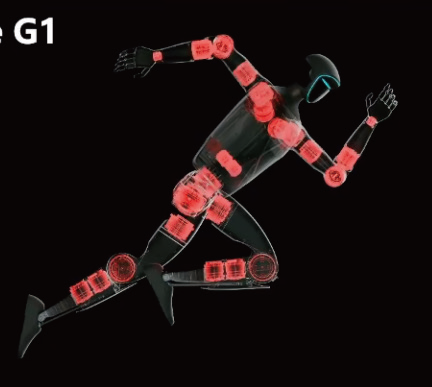

2024 年5 月,宇树又发布了第二款人形机器人——G1 工程机,8 月发布了量产版本。工程机器人也是整合了宇树过去几年对四足机器人、人形机器人的软件、工业设计的经验,所以虽然这款机器人稍小一点,只有1.3米高,但无论它的外观、性能/ 关节灵活性、产品完成度都很高。宇树已经快要完成量产化的设计改造,预计年底前就可以量产。

图2 是G1 的关节布置,可见非常流畅和漂亮。这里有个“梗”,其实这种关节布置对于动力控制来说并不是最优的,腿有点重且不方便控制。但是为什么敢这么做?原因就是AI 技术的进步,使很多原本不容易控制的变得容易解决了。

2024 年5 月G1 刚发布时展示的一些运动性能。里面用了一些传统控制算法,但是大部分还是用了深度强化学习来实现。

目前产品的完成度还是非常高的,不怕踹、打,关节的灵活性也非常高,可以实现很多人实现不了的高难动作,还轻便可折叠(如图3)。

H1 是在2024 年初时推出,可能是全球第一款可实现空翻的纯电机驱动的人形机器人,动力性能非常强劲,也是用了“模仿学习+ 强化学习”的算法,因为这种机器人不太好控制,用传统算法很难实现空翻(图4)。通过“模仿学习+ 强化学习”,还实现了奔跑及跳舞等动作。

在这次展会现场,宇树长时间地在演示这个技术,可见稳定性非常高。因为AI 技术相对于别的技术,最大的一个点就是它对硬件和对机器人的泛用性还是非常好的,哪怕硬件有一点点偏差,它还是可以有很稳定的控制。

上述主要是基于深度相机的端到端深度强化学习。实际上,如果对于复杂地形也可以训练。包括对于四足机器人——它本身也可以2条腿走路,包括连续的空翻,也是基于模仿学习和深度强化学习做的。这些功能早几个月前,宇树就已经OTA 升级给全球客户使用了。宇树还推出了基于开源的遥操作数据采集系统(图5)。因为目前AI 技术基本上是数据驱动的,因此对人形机器人的数据采集是刚需的,所以宇树做了一套比较简单的轻量化的数据采集系统。但这还需要更多完善。

2024 年年中,宇树在基于模仿学习和深度强化之上做了G1 的一些升级性动作(图6)。

3 宇树的下一步规划

人们可能觉得宇树的机器人现在已经做得不错了,但实际上要做的事情还非常多。

例如,目前这些动作基本上是每个动作单独做AI训练的,但在很多场景下,人们还是希望一台机器人可以自动切换所有的动作,而不需要人为地去切换动作,即一个通用AI机器人能做所有的事情。这也是通用AI希望达到的目标。这也是用深度相机来做端到端训练的。

4 “深度强化学习”的近期发展方向

● 全身任意姿态或舞蹈等动作的模仿深度强化学习。

● 复杂地形下的全身任意稳定运动。

● 手部:对于复杂物品或零部件,有较复杂的灵巧操作。现在全球范围内用模仿学习可以实现较大物体的操作,例如把水杯从一处拿到另一处。但是对于更精细一点的活儿还做不好,例如焊电路、穿针引线、打一个结等。但这些都是非常值得做的。

● 基于图像或深度数据等感知数据的强化学习导航避障。

5 未来能做的激动人心的事:世界模型=AGI

● “世界模型”包括对时空和物理规律的理解再好高骛远一下,展望人形机器人能做的更加激动人心的一些事情。王兴兴看好“世界模型”,并认为具身智能是实现“世界模型”的一个方向。不过需要指出的是,这可能不是宇树目前能实现的,希望全球的从业者都能推动这件事情,而且这将是未来最激动人心的时刻。

“世界模型”包括机器人对自身时空的理解,以及对物理规律的理解。实际上,人们也知道现在的AI 技术对机器人的身体和对世界的理解是完全不够的,例如对重力、摩擦力和接触的理解是非常差的。如果有更好的AI能把机器人对自身的认知和对环境的理解做出来,就可以大大推动整个机器人行业的进步。

而且“世界模型”本身就是AGI 的一个方向,可能就是用来真正实现AGI 的。因为AGI 最大的发展点是大部分人能做的事情它应该都能做,包括开车、洗衣做饭、工厂工作。如果“世界模型”对世界本身有很好的建模,那么这种目标就差不多要实现了。例如特斯拉的FSD(完全自动驾驶),“世界模型”对整个车辆和周边环境都会有建模,包括对前车的速度判断、撞击等一些未来动作的预判,也会有好的建模和理解。

● 大模型的发展离不开“身体”

另一方面,很多做AI 的企业,包括OpenAI,对大脑的重视程度非常高。但身体才是最重要的,因为大脑和身体是分不开的。

举个简单的例子,这也是王兴兴从小就非常困扰的一个问题:做梦的时候,为什么会突然感觉从悬崖上往下掉,或者在梦里为什么跑不快?这个问题在他本科的时候才想通,其实原因很简单:人在睡觉的时候,大脑跟身体的感知是完全断开的,你不能感知到身体的皮肤,也不能控制肌肉,所以你的大脑本身是没有物理世界连接的。

所以在我们原本的认知里,跑步时,我每跑一步脚都是要跟地面有接触的,接触以后你的大脑知道我接触到地面了,我要迈另外一只脚。但是在我们做梦的时候,由于跟物理世界脱离了关系,你的大脑其实不知道你已经踩到地面了,所以你永远感觉你的脚轻飘飘的,跑不快,没办法使力,所以这也是体现了目前的大的身体的重要性。包括为什么会觉得从悬崖上往下面掉,因为你在跟身体断开连接的时候,你其实并不知道你的身体跟床是接触的,你觉得你是悬空的,所以你往下掉。这也回答了一个非常简单的问题,就是为什么现在大语言模型会有幻觉?简单地解释就是目前的大语言模型活在梦里,对物理世界是脱离连接的——不能感受到自己的身体,也不能看到,也不能撞到头部,也不能眨眼睛……。所以它整个的闭环跟物理世界的连接断开以后,让所有的大语言模式都是活在梦里。由于它是非常虚拟的,所以会有很多幻觉、不真实——它自己都不知道做的事情真不真。原因也非常简单,例如有人在说梦话,如果你跟他说一句话,他也回答你的问题。但是说梦话的人所说的是稀里糊涂的,没有逻辑可言。所以这也体现了身体的重要性。

● 人和动物“换脑”会如何?

王兴兴又分享一个有趣的想法,是他小时候非常喜欢的思考:人为什么比动物聪明?如果把人的大脑放到狗里,或者猪里,或者把猪的大脑放到人里,到底哪种结构可以诞生更多的智能?

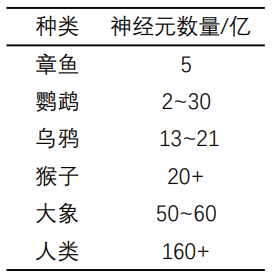

他一直在反思,这是受多方面的原因限制的,而且可能物理限制还会更多。例如他很怀疑:如果把一只猴子的大脑放到人的身上,Ta 照样是可以说话的。

但是为什么猴子不能说话?原因非常简单,其喉咙和声带不支持它说话。举个最简单的例子,像鹦鹉的神经元其实是比较少的,比较聪明、能说话的鹦鹉大概只有2~30 亿的神经元,但是猴子的神经元跟它差不多,甚至猩猩的神经元比它更多,但是为什么猩猩说不了话,而且只能发一些低级的声音?可能人们猜测是声带的原因。这也可以解释鹦鹉为什么能说话?因为它很喜欢吃坚果,在吃坚果的过程中,它的喉咙和舌头锻炼得非常灵活,所以它没有物理限制。所以这也是很大层面上一些高等动物,诸如一些海豚、鲸等,是因为它们的声带限制了它们的发声。

表1 部分动物与人类的神经元数量

所以除了纯粹的AI,还需要:①对内,有身体,包括对视觉和身体的感知都非常重要,包括对实时的数据采集;②对外:对物理世界的了解,包括对一些碰撞、重力、摩擦力、光学等的理解。

● 人的输出能力有潜力可挖

王兴兴还介绍了一个有趣的观点:目前人的数据输出能力是非常弱的,而人的数据输入能力非常强,因为人有眼睛,看一张图片或视频的时候,数据的输入量非常大,至少每秒钟几百或几千kB 的数据量。但是人输出数据的能力其实非常弱,只能通过说话或者敲键盘。最顶尖的人敲键盘的速度大概可能也就1 秒几个字而已——比特流是非常低的。所以如果有一种输出设备诸如人机接口可以把人的数据输出能力大大提升,这对人本身的智能提升,包括工作效率会有非常大的提升。而且这项技术可以通过不需要用大脑植入式的设备,只要在表皮能连接上一些神经元就可实现。

所以如果有一些神经学或生物医疗相关的朋友,没准可以试试这个方向?

王兴兴为什么愿意分享这个方向?因为他觉得自己没有能力去做。欢迎有兴趣、有能力的朋友去尝试一下,或者与他一起去做这件事情。

另外他又分享了一个体验:他小时候看一些电视剧,看到有些武林高手的耳朵是可以动的,就是他们的肌肉可以控制耳朵动,但是普通人实现不了。其实这个本领是可以锻炼出来的。例如王兴兴在高中上英语课时总分心,有一段时间练习用想法控制脑袋壳上一块肌肉的运动,练习了好几天,突然有一天就能控制那块肌肉了!

未来,也许用外部的脑机接口直接连接/ 替掉一些神经元,然后去锻炼一下,就能作为很好的人机接口输出。

● 比人类更高级的智能形态会什么样?

现在和曾经的AI 网络是模仿人类的,但又不完全跟人类一样。这就像飞机一样,飞行原理是参考了鸟的飞行原理,但是跟鸟又不完全一样。所以用计算机实现的智能形态,跟人的智能形态多少还是会有差异的。

● AGI的黎明快要到来

在2024 年年初的时候,王兴兴预估在2025 年年底之前,在全球至少有一家实验室或公司可以把通用型的机器人AI模型给做出来。当然不知道是哪一家,有可能是中国,也有可能是美国的公司或者实验室。

● 尽可能相信AI

有了生成式AI,当下是迄今人类历史上最激动人心的时刻。

● 跨尺度智能

除了跟人一样大小的人形机器人,还可以做更小更小的人形机器人,也可以做更大的人形机器人。例如可以做细胞大小的人形机器人,可以做比如100 万个,然后当人生病的时候,只要把100 万个人形机器人打到身体里面,就可以修复组织[1]。当然这个概念还比较遥远。

参考文献:

[1] 最小行走机器人能做微观测量[N].熊文苑,译.参考消息.2024-12-8.

有话要说...